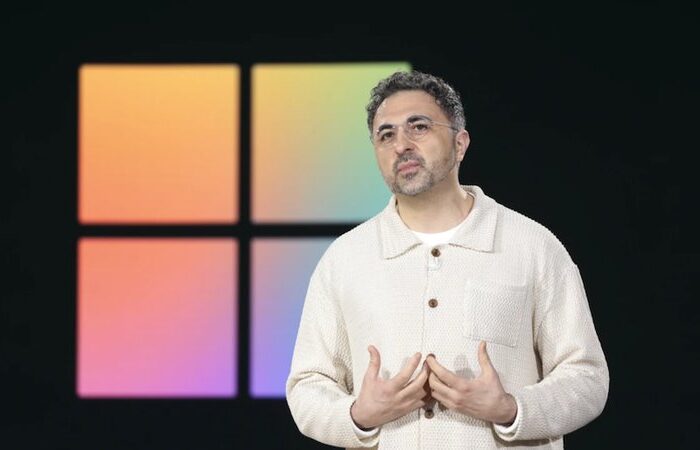

Alex Rivlin, un empresario de Las Vegas, se convirtió en protagonista involuntario de una estafa digital que ilustra los peligros de la inteligencia artificial mal utilizada

Las nuevas tecnologías de inteligencia artificial han dado lugar a una evolución peligrosa en las estafas digitales, poniendo en riesgo incluso a los internautas con más experiencia. El caso de Alex Rivlin, quien perdió dinero tras confiar en un número de atención al cliente falso recomendado por la función AI Overviews de Google, evidencia cómo la IA puede amplificar el alcance y la credibilidad de los fraudes tradicionales en línea.

Tanto grandes compañías tecnológicas como usuarios se ven ante el reto de nuevas formas de manipulación, que crecen al compás de los avances en automatización y manejo de información a escala global.

El caso de Alex Rivlin

Alex Rivlin, un empresario de Las Vegas con experiencia en tecnología, se convirtió en protagonista involuntario de una estafa digital que ilustra los peligros de la inteligencia artificial mal utilizada. Mientras planeaba un viaje por Europa, buscó en Google el número de atención al cliente de una conocida naviera. La función AI Overviews de Google le presentó como primer resultado un número telefónico que resultó ser falso y estaba gestionado por estafadores.

La interacción que Rivlin mantuvo con estos supuestos agentes resultó tan convincente que llegó a abonar 768 dólares creyendo que estaba contratando un servicio legítimo. Las tarifas, el trato al cliente y los descuentos parecían totalmente auténticos. Sólo cuando aparecieron cargos inusuales en su tarjeta Rivlin sospechó y logró cancelar el pago, evitando así mayores pérdidas.

Este episodio revela cómo la IA puede amplificar y automatizar fraudes que hasta hace poco requerían métodos mucho más rudimentarios. Los ciberdelincuentes, en vez de enviar mensajes masivos o correos fraudulentos, ahora siembran en la web números falsos de atención al cliente y manipulan los algoritmos de los buscadores para conseguir aparecer entre los primeros resultados.

El error de Rivlin no fue un descuido, sino el resultado de confiar en una respuesta rápida y aparentemente oficial proporcionada por la tecnología de inteligencia artificial.

Inteligencia artificial e ingeniería del fraude: una combinación preocupante

El auge de la IA en buscadores y asistentes automáticos ha redefinido la manera en que los usuarios acceden a datos, facilitando respuestas rápidas sobre empresas, servicios o contactos. Sin embargo, este acceso instantáneo se ha convertido en una puerta de entrada para estafadores que manipulan la información visible en la red.

Como ejemplifica el caso de Alex Rivlin, incluso individuos con conocimientos tecnológicos pueden ser víctimas de trampas sofisticadas cuando las respuestas automáticas tienen apariencia confiable.

Los delincuentes digitales emplean técnicas antiguas con métodos actualizados: inundan foros, páginas de reseñas y webs con falsos números de contacto atribuibles a compañías reconocidas, desde navieras hasta aerolíneas.

Al ganar visibilidad y repetición, estas menciones engañan a los algoritmos de plataformas como Google, llevándolos a sugerir datos fraudulentos en los resúmenes de IA, que muchos interpretan como fuentes legitimas. Esta automatización hace que lo que antes requería una búsqueda minuciosa, hoy se presente como la solución a un solo clic de distancia.

El perfeccionamiento de estas tácticas, gracias a la IA, ha permitido que el fraude escale tanto en rapidez como en eficacia, penetrando sectores donde la inmediatez en la respuesta es clave y la confianza suele basarse en la primera información recibida.

Resultados de IA manipulan la confianza

El impacto de estos nuevos métodos afecta a un abanico de plataformas más allá de Google. Asistentes como ChatGPT han replicado información contaminada en sus recomendaciones, lo que confirma que la amenaza va más allá de un solo proveedor tecnológico.

La inteligencia artificial, al organizar y resumir lo que encuentra disponible online, puede actuar como agente multiplicador de datos falsificados, propagando engaños concebidos por expertos en manipulación de la visibilidad digital.

Las consecuencias ya resultan palpables. Casos de suplantación afectan a varias compañías de cruceros, aerolíneas y servicios populares, mientras que los fraudes ganan tracción entre usuarios urgidos por encontrar soluciones inmediatas.

La combinación de la autoridad percibida de la IA y la velocidad de respuesta convierte el riesgo marginal de los números de contacto falsos, presentes desde hace años, en una amenaza generalizada de escala masiva. Incluso personas habituadas a navegar entornos digitales seguros pueden caer en la trampa, como demuestra la experiencia de Rivlin.

Cómo responden las grandes tecnológicas y qué pueden hacer los usuarios

Ante la expansión de estos fraudes, compañías como Google y OpenAI reconocen el problema, aunque insisten en su carácter aislado y en las medidas de control desplegadas. Google asegura que ha eliminado algunos números fraudulentos detectados en sus resultados y anticipa mejoras en la gestión de respuestas para consultas inusuales.

OpenAI, por su parte, advierte sobre los tiempos de actualización en sistemas como ChatGPT después de identificar y retirar páginas problemáticas, señalando la dificultad de anticipar cada manipulación.

Sin embargo, el desafío es complejo. Los especialistas señalan la necesidad de priorizar fuentes verificadas y bases de datos oficiales en los sistemas de inteligencia artificial, especialmente para consultas sensibles vinculadas a servicios reales. Aunque existen mecanismos de supervisión, la velocidad con la que los estafadores pueden infiltrar información errónea sigue superando a las medidas reactivas habituales.